近年来,文生图像和文生视频模型取得了重大进展并获得了广泛关注,涌现了DALLE 2/3、Stable Diffusion、Stable Video Diffusion等一批代表性模型。2024年2月15日,OpenAI发布了AI文生视频大模型Sora,Sora不仅能够一段文字生成长时间高质量流畅视频,更可为通用物理世界模拟提供一种有效的构造方式,为未来的多媒体内容创作与体验开辟了新的可能性。

自2023年以来,哈尔滨工业大学金沙js9线路中心机器学习研究中心左旺孟团队针对文生图像的个体可控性差、文生3D的多面问题、以及文生视频的单帧质量较低和时域不平滑现象,提出了一系列新模型和新方法,在定制化图像生成、文生3D和文生视频等方面取得显著进展,成果相继发表于ICCV、AAAI、ICLR和CVPR等领域顶级会议。

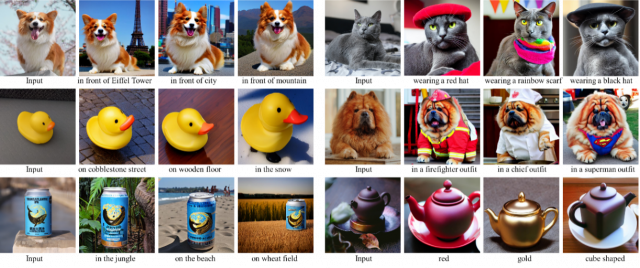

在定制化图像生成方面,团队提出了一种基于模型的快速定制化文本到图像生成方法ELITE。ELITE利用全局编码网络将视觉概念直接映射为文本嵌入,并在训练时引入多层特征策略以提升文本嵌入的可编辑性。与此同时,ELITE采用局部编码网络来补充细节,以更好地平衡定制化生成的一致性和可编辑性。实验表明ELITE可以在极短的时间内(小于0.1秒)学习新的视觉概念,并可以进行高效的编辑。ELITE为定制化文本图像生成领域带来了新的方法和思路,不仅提高了生成速度,还保持了生成图像的质量和可控性,对于实际应用中快速生成特定个体的图像具有重要意义。

与现有方法比较

Elite生成结果

在文生3D方面,团队分析了多面(Janus)问题的产生原因,即2D扩散模型中的视角偏差和优化目标的过拟合。提出了一个两阶段的2D提升框架DreamControl,通过将初步的NeRF场景作为3D自身先验,利用基于ControlNet的分数蒸馏生成精细3D模型。在第一阶段,提出了自适应视角采样和边界完整性度量。在第二阶段,利用条件LoRA和加权分数进一步优化3D模型的细节纹理,有效避免了文生3D的多面问题。

文生3D结果

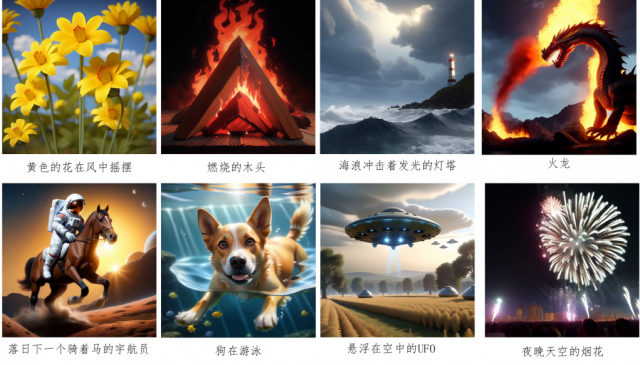

在文生视频方面,团队分别研究了有无引导信息的文生视频任务。针对引导视频生成,团队提出了ControlVideo,利用交错帧平滑器、完全互注意力机制和分层采样策略,使得仅用单张NVIDIA 2080Ti GPU生成稳定视频成为可能。针对文生视频,团队提出了一种无需训练的即插即用视频质量提升方法VideoElevator,利用文生图像的的优越性能提升文生视频性能。VideoElevator主要包括时域运动改善和空域质量提升模块,时域运动改善模块利用封装的文生视频模型来增强时间一致性,空域质量提升模块利文生图像模型增加更多逼真的细节。VideoElevator不仅可以通过基础文生图像模型改进文生视频基线模型的性能,还通过个性化文生图像模型实现风格化视频生成。

与Sora相比,VideoElevator能够达到相当的图像帧质量,但在视频生成的长度和场景复杂性方面仍有显著差距。今后,团队将围绕复杂场景长视频生成及真实性建模继续开展研究,力争在整体上达到接近Sora的性能,并在若干单点技术上实现性能赶超。

文生视频结果

除日常生活和娱乐外,在许多航空航天和工业应用中,AI视觉内容生成技术还可用于生成训练数据,缓解数据稀缺和分布不均衡,支持人工智能系统的快速开发与迭代更新。

相关科研成果:

[1] Yuxiang Wei, Yabo Zhang, Zhilong Ji, Jinfeng Bai, Lei Zhang, Wangmeng Zuo,ELITE: Encoding Visual Concepts into Textual Embeddings for Customized Text-to-Image Generation, ICCV 2023.

[2] Yufei Cai, Yuxiang Wei, Zhilong Ji, Jinfeng Bai, Hu Han, Wangmeng Zuo, Decoupled Textual Embeddings for Customized Image Generation, AAAI 2024.

[3] Tianyu Huang, Yihan Zeng, Bowen Dong, Hang Xu, Songcen Xu, Rynson WH Lau, Wangmeng Zuo, Textfield3d: Towards enhancing open-vocabulary 3d generation with noisy text fields, ICLR 2024.

[4] Tianyu Huang, Yihan Zeng, Zhilu Zhang, Wan Xu, Hang Xu, Songcen Xu, Rynson WH Lau, Wangmeng Zuo, Dreamcontrol: Control-based text-to-3d generation with 3d self-prior, CVPR 2024.

[5] Yabo Zhang, Yuxiang Wei, Dongsheng Jiang, Xiaopeng Zhang, Wangmeng Zuo, Qi Tian, Controlvideo: Training-free controllable text-to-video generation, ICLR 2024.

[6] Yabo Zhang, Yuxiang Wei, Xianhui Lin, Zheng Hui, Peiran Ren, Xuansong Xie, Xiangyang Ji, Wangmeng Zuo, VideoElevator: Elevating Video Generation Quality with Versatile Text-to-Image Diffusion Models, Arxiv 2024.